有没有想过,要是能让一个虚拟形象像真人一样开口说话,还能配上生动的头部和身体动作,那该多酷?如今,这个看似科幻的场景已经通过一些超厉害的开源项目成为现实啦!

今天,我就带大家走进数字人开源的神奇世界,看看阿里、腾讯等大厂都推出了哪些让人惊掉下巴的 “秘密武器”。

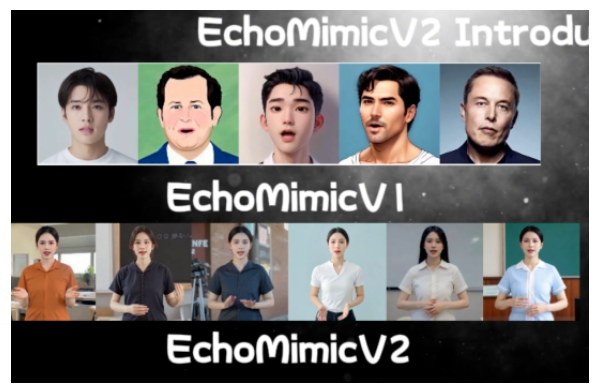

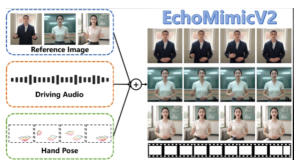

一、阿里开源:EchoMimic V2,数字人动画的魔法师

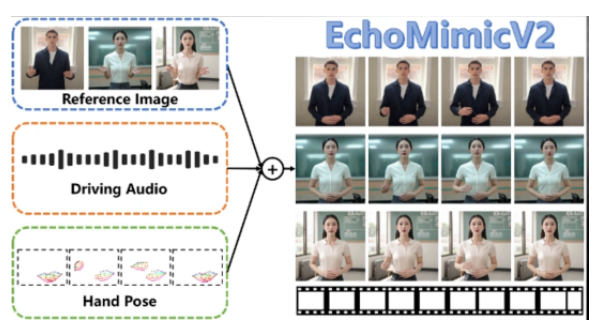

阿里达摩院搞出的 EchoMimic V2 简直就是数字人领域的一颗 “重磅炸弹”!它是一款超牛的基于语音驱动的肖像动画生成工具,专门用来打造高质量的数字人半身动画视频。以前,让虚拟形象说话且口型同步就已经很不容易了,可 EchoMimic V2 不满足于此,还能给虚拟形象加上头部和身体动作,而且首次实现了身体动作和口型的完美全同步,这技术简直绝了!

1、能听懂中文和英文的神奇工具

不管你输入的是中文语音还是英文语音,它都能轻松应对。想象一下,你给它一段中文的故事音频,虚拟形象马上就能绘声绘色地 “讲” 出来,不仅口型严丝合缝,身体还会随着故事情节做出相应的动作,摇头晃脑、举手投足间,活脱脱一个专业的 “故事讲述者”。换成英文音频,同样不在话下,这跨语言的能力,简直无敌。

2、核心技术

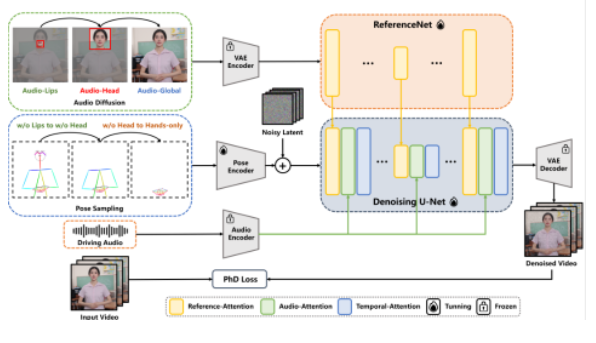

音频 – 姿势动态协调策略:这就像是给虚拟形象的动作和声音之间搭了一座 “智能桥梁”。它通过姿势采样和音频扩散的方式,让半身细节和面部表达力都得到了极大的增强,同时还巧妙地减少了那些不必要的条件冗余,让生成的动画更加自然流畅。

Head Partial Attention:这项技术就像一个细心的 “整合大师”,专门负责整合头部数据。精心设计了特定阶段去噪损失,以此来不断优化动画质量,让虚拟形象的头部动作看起来更加真实,仿佛真的有自己的想法和情感在里面。

手部姿势序列生成:它可以根据参考图片、音频剪辑以及手部姿势序列,生成超高质量的动画视频,确保音频内容和半身动作完美一致。比如说,你想让虚拟形象一边说话一边做手势,它就能精准地完成这个任务,让虚拟形象的表现力更上一层楼。

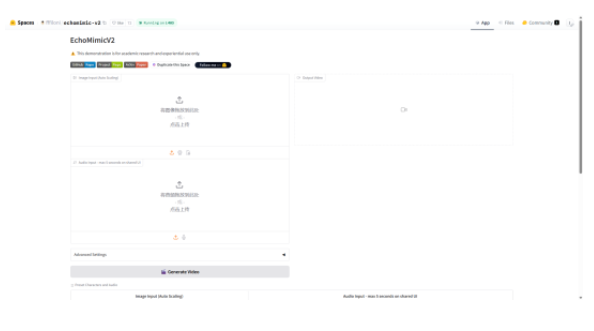

要是你也想体验一下这个神奇的工具,

开源地址双手奉上:

https://github.com/antgroup/echomimic_v2 ,

还有在线 Demo 哦:

https://huggingface.co/spaces/fffiloni/echomimic-v202 ,

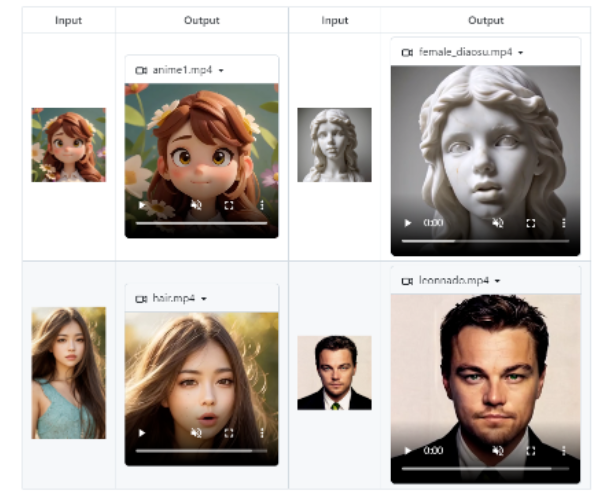

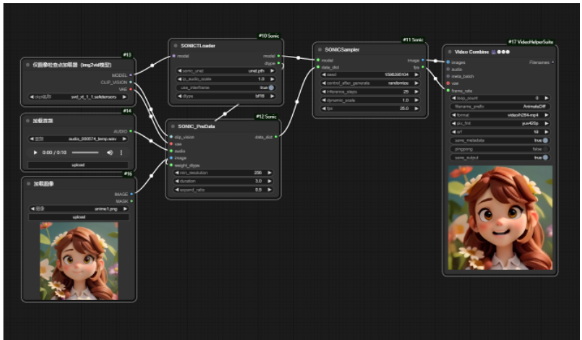

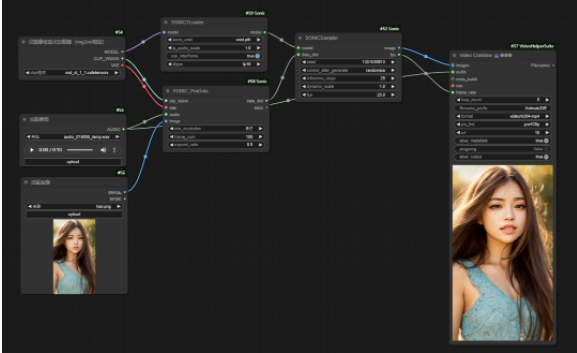

二、腾讯 & 浙大联合开源:Sonic,让静态照片 “活过来” 的魔法棒

腾讯和浙江大学联合推出的 Sonic 同样厉害到不行!它就像一根拥有魔力的魔法棒,只要给它一张静态照片和一段音频,不管是歌曲还是对话,它就能让画面中的人物瞬间 “活过来”,自然地开口说话。不管是打造虚拟偶像,还是用于影视创作、教育解说,Sonic 都能大显身手,堪称数字人开源界的 “多面手”。

技术亮点闪耀全场

1、分层对齐框架

Sonic 把动画生成这件事拆分成了唇部同步、表情渲染、头部运动三层。就像搭积木一样,一层一层地精心搭建,逐级优化细节,这样生成的动作超级自然流畅,彻底告别了那种让人尴尬的机械感。

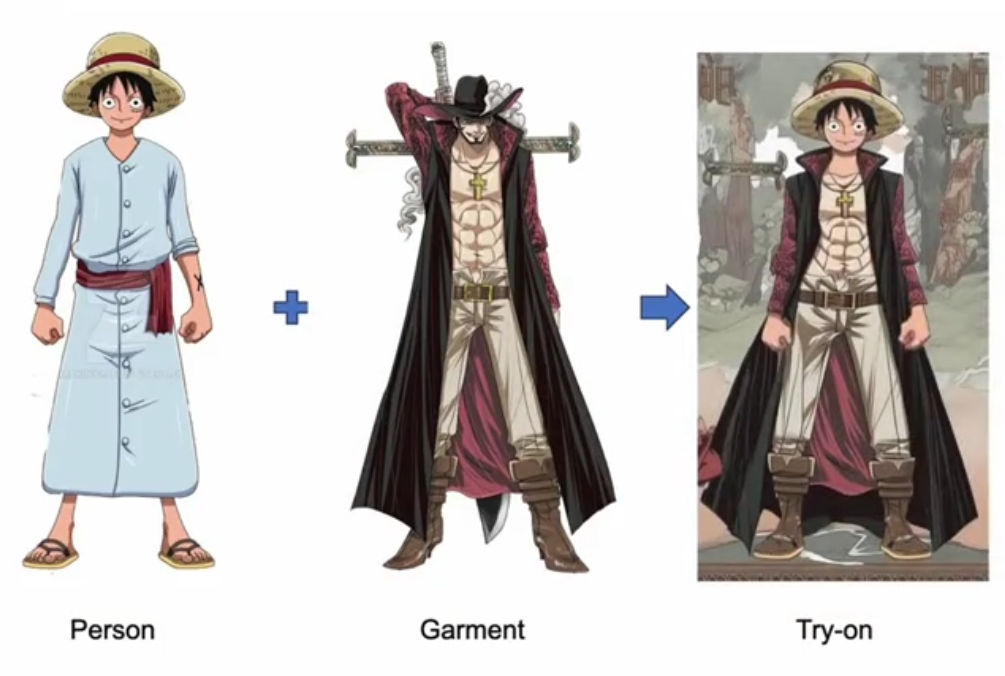

2、跨身份泛化能力

不管你给它的是真人照片、动漫角色图片,还是从各种奇怪角度拍摄的照片,Sonic 都能精准识别,然后生成和角色高度契合的动画效果。哪怕是一个小小的动漫头像,它都能让其 “活灵活现” 地说话,这适应能力,简直无敌。

3、长视频稳定性

很多传统工具在生成长视频的时候,画面容易出现扭曲变形的问题。但 Sonic 有自己的 “秘密武器” —— 动态锚点技术。有了这个技术,它在长时间生成视频时,也能保证画面稳定,不会出现讨厌的伪影,让你的长视频创作更加省心。

4、开源易用

Sonic 已经集成到了 ComfyUI 里,对于开发者来说,这就像是有了一个贴心的 “开发助手”,可以快速上手。而且社区里还有超多丰富的案例和教程,就算是新手也能轻松学会。

开源地址在这里:https://github.com/jixiaozhong/Sonic ,

在线 Demo 戳这里:http://demo.sonic.jixiaozhong.online/ ,

huggingface 链接:https://huggingface.co/spaces/xiaozhongji/Sonic/ ,感兴趣的小伙伴别错过。

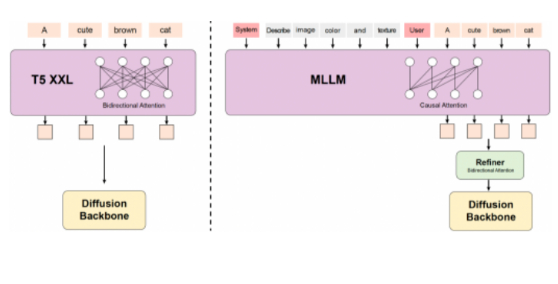

三、腾讯开源:HunyuanVideo,视频生成界的 “超级引擎”

腾讯混元团队开源的 HunyuanVideo 虽然不算数字人模型,但它可是视频生成界的一个 “超级引擎”!它的视频生成性能那叫一个强,和那些领先的闭源模型相比,不仅不逊色,甚至还更胜一筹。

腾讯混元团队为了让 HunyuanVideo 这么厉害,可是下了大功夫。他们进行了海量的实验,还实施了一系列针对性超强的设计,就是为了保证视频的视觉质量超高、运动多样性丰富、文本和视频完美对齐,而且生成过程特别稳定。根据专业人工评估结果,HunyuanVideo 的表现直接把之前的模型,像 Runway Gen – 3、Luma 1.6 以及 3 个表现最好的中文视频生成模型都给 “比下去” 了。

要是你想探索这个超厉害的视频生成基础模型,开源地址:

https://github.com/Tencent/HunyuanVideo 。

这些数字人开源项目简直太牛了,为我们打开了数字世界的新大门。不管你是开发者、创意工作者,还是对数字人感兴趣的普通爱好者,都赶紧去试试这些神奇的工具吧,说不定下一个数字人领域的 “大神” 就是你!

暂无评论内容